Beiträge

Argumentative Delphi-Verfahren sind nicht neu. Sie wurden bereits in den experimentellen Studien von Dalkey in den 1960er Jahren eingesetzt (Dalkey 1968, 1969a,b, Dalkey et al. 1969; Dalkey und Helmer 1963, Dalkey et al. 1972). Sie basieren damit auf den üblichen Delphi-Verfahren in zwei oder mehr Runden mit Feedback und der Möglichkeit, in der zweiten oder späteren Runde die eigenen Einschätzungen unter Berücksichtigung der aggregierten Antworten anderer Experten zu überdenken und bei Bedarf zu revidieren, ohne sich rechtfertigen zu müssen oder „das Gesicht zu verlieren“ (Cuhls 1997; 2019, Häder 2009). Bei den argumentativen Delphi-Verfahren werden die Teilnehmenden gebeten, Argumente oder Begründungen für die eigene Einschätzung zu geben, d.h. zum Beispiel zu begründen, warum man eine frühe bzw. späte Verwirklichung des Themas annimmt oder warum man das Thema für besonders zukunftsträchtig hält. Die Frage nach einer Begründung ist dabei jeweils an eine quantitative Einschätzung, die später statistisch ausgewertet wird, geknüpft.

Das „Dynamic Argumentative Delphi“ (DAD) geht dabei einen Schritt weiter. Es baut auf den Vorteilen des Realtime-Delphis auf und wurde inzwischen mehrfach erfolgreich getestet. [1] Das Hauptziel des Ansatzes ist es, Online-Delphi-Befragungen mit einer großen Anzahl von Teilnehmern (Hunderte oder mehr) zu ermöglichen, wobei der interaktive "argumentative", d.h. auf Rechtfertigung basierende Charakter des traditionellen Delphi beibehalten wird. Da die Bearbeitung der Argumente der Befragten typischerweise mit einem hohen manuellen Aufwand über mehrere Runden verbunden ist und damit das Haupthindernis für eine hohe Teilnehmerzahl darstellt, ist dieser Prozess beim DAD durch die Einführung einiger einfacher Regeln automatisiert.

Ein Realtime-Delphi ist dadurch charakterisiert, dass es eine Befragung ist, in der direkt und in Echtzeit, d.h. sofort, Feedback über die Antworten der bisherigen Teilnehmer und Teilnehmerinnen gegeben wird (siehe Gerhold 2019; Cuhls 2019, Gnatzy et al. 2011; Gordon und Peace 2006 u.a.), so dass die Teilnehmenden auf der Basis der Ergebnisse die eigene Meinung überdenken und ändern können - oder auch nicht. In der Regel können sie dies sogar mehrfach tun und so oft „wiederkommen“ wie sie möchten. Erste Echtzeit-Delphi-Studien wurden bereits 2006 durchgeführt (Gordon und Peace 2006; Cuhls et al. 2007, Friedewald et al. 2007; Zipfinger 2007). Realtime Delphi-Studien (RTD) sind im Grunde nur online möglich, wenn sie die Anonymität der Teilnehmenden wahren möchten. [2] RTD nutzen daher die Vorteile der besonderen Gruppendynamiken in Delphi-Studien und verbinden sie mit wesentlich direkterer Kommunikation unter den Teilnehmenden ohne die Anonymität der Befragung aufzugeben. [3] Es existieren bereits einige Software-Versionen, um online Delphi-Studien durchzuführen, für einen Überblick siehe Aengenheyster et al. 2017.

Delphi-Befragungen fordern den Teilnehmenden einiges ab. Sie müssen die Thesen lesen, erfassen und einschätzen - und das Ganze mehrfach, d.h. mindestens zweimal, um die Meinung ändern zu können, denn sonst ist es kein Delphi, sondern eine einfache Zukunftsbefragung. Dabei benötigt die Beurteilung eine Durchdringung des jeweiligen Themas.

Außerdem wird die Einschätzung jeder einzelnen Person unter bestimmten Prämissen und Voreingenommenheiten getätigt. Die Argumente zur Einschätzung, die Prämissen, oder „was sich der Experte oder die Expertin dabei gedacht hat“, sollen im argumentativen Delphi erfasst und auswertbar gemacht werden. Dies ist aufwändiger für die Teilnehmenden, weil sie es schreiben müssen und nicht einfach nur einen Wert notieren oder anklicken. Es ist auch aufwändiger für die Auswerter, weil nur inhaltliche, manchmal bruchstückhafte Auswertungen möglich sind. Textmining-Ansätze oder die Nutzung von MaxQDA sind zwar von der Autorin ausprobiert worden, waren aber bisher nur bedingt hilfreich. Bei der Auswertung können zusätzlich die Biases der Auswertenden ins Spiel kommen.

Anders als die aggregierten statistischen Auswertungen sind die Argumente Einzelmeinungen, die - wenn zurückgespielt - entgegen dem Delphi-Prinzip wieder zu dominanten Meinungen werden können. Statistiken sind in der Auswertung automatisierbar und damit einfacher zu handhaben. Trotzdem bieten die Argumente inhaltliche Anhaltspunkte und Begründungen für die jeweiligen Einschätzungen und damit wertvolle Inhalte oder Zusatzinformationen.

Warum nun auch noch Dynamik einbringen und wie funktioniert sie? Das Hauptziel des Ansatzes ist es, Online-Delphi-Konsultationen mit einer großen Anzahl von Teilnehmern zu ermöglichen, ohne den interaktiven "argumentativen" (d.h. auf Rechtfertigung basierenden) Charakter des traditionellen Delphi in kleineren Gruppen zu verlieren. Da die Bearbeitung der Argumente der Befragten typischerweise mit einem hohen manuellen Aufwand über mehrere Runden verbunden ist (und damit das Haupthindernis für die Erweiterung der Teilnehmerzahl darstellt), hat das dynamische, argumentative Delphi diesen Prozess durch die Einführung einiger einfacher Regeln automatisiert.

Jede quantitativ zu bewertende Delphi-Aussage (z.B. zu Wahrscheinlichkeit, Wichtigkeit, Auswirkung etc.) wird im Online-Fragebogen mit zwei bis drei 'Start'-Argumenten verknüpft, die - zusammen mit allen später von den Befragten hinzugefügten Argumenten - für die Teilnehmenden immer sichtbar sind. Der sich bei jeder Teilnahme erweiternde Satz von Argumenten dient, wie in traditionellen Delphi-Formaten, als Begründung für die quantitativen Schätzungen. Die Befragten werden aufgefordert, ihre quantitative Schätzung einzugeben und diese zu begründen, indem sie mindestens ein bereits vorhandenes Argument auswählen oder mindestens ein neues Argument oder beides angeben. Die maximale Anzahl von Argumenten, die von jedem einzelnen Befragten hinzugefügt bzw. ausgewählt werden können, ist normalerweise auf zwei oder drei beschränkt.

Die Liste und die Häufigkeit der Argumente, die mit den neu ausgewählten/eingeführten Argumenten aktualisiert werden, ist für nachfolgende Befragte immer sichtbar (Echtzeit-Aktualisierung). Die Argumente in der Liste sind nach der Anzahl der während der Übung gesammelten Stimmen (Anzahlen werden angegeben) geordnet. Im Gegensatz zu der ständig aktualisierten Liste der Argumente sind die eigenen quantitativen Schätzungen nur für den einzelnen Teilnehmer, der sie erstellt hat, sichtbar.

Mit diesem Ansatz ist es möglich, das Delphi entweder auf eine einzige „Runde“ zu beschränken und bei dieser die Möglichkeit zu geben, so oft wie gewünscht zu antworten, oder eine zweite Runde hinzuzufügen (z.B. nur für die Befragten, deren Schätzungen über/ unter einem bestimmten Schwellenwert im Vergleich zum Gruppendurchschnitt oder Median liegen). In beiden Fällen bleiben die Vorteile der traditionellen Delphi-Methode erhalten. Es ist auch möglich, die Anzahl der Argumente auf ein überschaubares Maß zu beschränken, da der Aufbau die Teilnehmenden davon abhält, bereits eingeführte Argumente zu duplizieren, genauso wie bei Abschweifungen, übermäßig langen Texten oder irrelevanten Überlegungen. Im Wesentlichen sind die Argumente "selbstbündelnd". Dadurch kann die Anzahl der Teilnehmer ohne anteiligen manuellen Bearbeitungsaufwand auf Seiten der Auswertenden sehr hoch sein und gleichzeitig wesentlich mehr Inhalt generiert werden.

Es ist aber auch möglich, eine einfache Zukunftsbefragung mit dynamischen Argumenten durchzuführen (Dynamic Future Survey). Dies ist dann der Fall, wenn den Teilnehmenden nicht die Möglichkeit gegeben wird, ein zweites Mal zu antworten bzw. die Einschätzungen zu revidieren. Praktisch bedeutet das, jede(r) Teilnehmende sieht die Einschätzungen derjenigen, die vorher geantwortet haben, sobald eine bestimmte Anzahl von Antworten vorliegt. [4] Der- oder diejenige antwortet dann jeweils auf dem Feedback-Stand zu einem bestimmten Zeitpunkt, was aber auch bedeutet, dass jede Person ein anderes Feedback erhält und sich von einem anderen Feedback beeinflussen lassen kann, was ohne die Delphi-Funktion (die Revisionsmöglichkeit) durchaus kritisch zu betrachten ist.

Wichtig ist daher bei einer dynamischen, argumentativen Delphi-Befragung, dass die Vorteile des traditionellen Delphi-Formats erhalten bleiben. Die Befragten reflektieren die statistischen Daten ebenso wie die Begründungen für ihre quantitative Schätzung. Sie antworten weiterhin anonym und können sich beeinflussen lassen, müssen es aber nicht. Dabei ziehen sie die Argumente der vor ihnen Antwortenden heran und stellen so ein gewisses Maß an Intersubjektivität in der Übung sicher. Teilnehmende werden nicht gezwungen, sich einer bestimmten Meinung anzuschließen. Die Teilnehmenden können - und werden dazu ermutigt - zum Online-Fragebogen zurückkehren, um die aktualisierten Argumentlisten zu konsultieren und ihre Argumente im Lichte der Argumente zu überprüfen und eine Neueinschätzung vorzunehmen, wenn sie dies für notwendig halten.

Kurz gesagt, die wichtigsten Vorteile des DAD sind die folgenden:

-

Die Teilnehmerzahl kann im Vergleich zu traditionellem Delphi und sogar zu typischen Online-Übungen erheblich erweitert werden. Die Teilnehmenden kommen in direkteren Austausch.

-

Im Vergleich zu einigen Online-Formaten ist der Konsenstest zur quantitativen Variable explizit mit Argumenten verbunden, so dass die üblichen Fallstricke bei der Mittelwertbildung der Meinungen etwas abgemildert werden. Es gibt nicht nur statistische Rückmeldungen.

-

Die Interaktion der Teilnehmenden konzentriert sich auf die wichtigsten / "beliebtesten" Themen bzw. Argumente und verhindert so Abschweifungen.

-

Es veranlasst die Befragten, bereits vorhandene Argumente in der ursprünglich formulierten Form auszuwählen, anstatt unnötigerweise "neue" Gründe hinzuzufügen, die bereits eingegebene Gründe teilweise oder ganz duplizieren.

-

Es erleichtert die Interpretation der "Bedeutung" oder Signifikanz des quantitativen Ergebnisses, indem hervorgehoben wird, welche Argumente eher dafür oder dagegen sprechen.

-

Trotzdem kann jede(r) seine eigene Meinung noch einmal überdenken und ändern, ohne sich rechtfertigen zu müssen. Anonymität bleibt gewährleistet.

BOHEMIA ist das Akronym eines Projektes für die Europäische Kommission. Der Langtitel lautet: Beyond the Horizon: Foresight in Support of the Preparation of the European Union’s Future Policy in Research and Innovation. BOHEMIA ist dabei ein umfassendes Foresight-Projekt, das mehrere Methoden kombiniert: Megatrend-Erfassung, Horizon Scanning, Interviews, Szenarien, Delphi-Methode, zielgerichtete Szenarien sowie eine Konsultation. Mit diesem Foresight-Ansatz sollte die Gestaltung (insbesondere die Themenfindung) für das neunte Rahmenprogramm für Wissenschaft und Technik der Europäischen Union in einer frühen Vorbereitungsphase ab 2016 unterstützt werden. Zum Zeitpunkt der Veröffentlichung dieses Beitrags ist das Rahmenprogramm unter dem Namen „Horizon Europe“ bereits in der Startphase.

Das Projekt BOHEMIA (2016 bis 2018) bestand aus mehreren methodischen Schritten, die aufeinander aufbauten. Die erste Phase war der Erfassung von Megatrends gewidmet, die zu Szenarien zusammengefasst wurden. Hier wurden in Zusammenarbeit mit dem neu gegründeten „Foresight Correspondent’s Network“ (FCN) bestehend aus Repräsentanten und Repräsentantinnen aller Abteilungen der EU Kommission jeweils ein „Beharrlichkeitsszenario“ („Perseverance scenario“, Business as usual) sowie ein Veränderungsszenario (change scenario, ein eher wünschbares Szenario) beschrieben (European Commission 2017a).

Die Delphi-Studie markierte die zweite Phase des Projektes BOHEMIA (European Commission 2017b und 2018) und begann mit Interviews bei Personen, die einen breiten Überblick über mögliche Zukünfte haben sowie einer halb automatisierten Abfrage zu technisch-wissenschaftlichen Zukunftsthemen. Aus diesen und den Ergebnissen eines Horizon Scanning (Ansatz insbesondere über Publikationen) wurden Thesen generiert und in einem moderierten, sogenannten „Scoping Workshop“ mit Teilnehmenden des FCN sowie externen Expert*innen diskutiert und ausgewählt. Die Thesen wurden den zuständigen Officers der Europäischen Kommission und dem Projektteam mehrfach überarbeitet und dann einer Bewertung unterzogen (zu Details siehe unten).

In einer dritten Phase des Projektes wurden die Ergebnisse der Delphi-Befragung ausgewertet und die Thesen, die zu den wichtigsten gehörten, zu sogenannten „Mini-Szenarien“ oder „zielgerichteten Szenarien“ (targeted scenarios) zusammengefasst. Diese 17 zielgerichteten Szenarien markierten besonders in den Fokus zu nehmende Forschungs- und Technologierichtungen, die häufig vom Bedarf her formuliert waren, z.B. Nr. 6. Defeating Communicable Diseases, Nr. 7 Emotional Intelligence Online, Nr. 8. Human Organ Replacement, oder Nr. 10. Low Carbon Economy (European Commission 2018, auch als einzelne Szenarien publiziert). Die Szenarien wurden einer weiteren Delphi-ähnlichen Bewertung unterzogen (Consultation). Die Endergebnisse enthielten Empfehlungen für politische Umsetzungen und wurden 2018 in einem Gesamtbericht veröffentlicht (European Commission 2018). Im Folgenden wird nur die Delphi-Studie näher beleuchtet.

Die BOHEMIA Online-Delphi-Befragung hatte mehrere Ziele vor Augen:

-

eine Liste von Einzelfragen zu erstellen, die im Rahmen der zukünftigen europäischen F&I-Politik und -Finanzierung behandelt werden können;

-

die Durchführung einer "Analyse der möglichen zukünftigen Entwicklung der sozioökonomischen sowie der wissenschaftlichen und technologischen Herausforderungen, Bedürfnisse und Möglichkeiten der EU im globalen Kontext";

-

eine "Abschätzung der wirtschaftlichen und gesellschaftlichen Nachfrage nach neu entstehenden Technologien und des wahrscheinlichen Zeitpunkts ihres Auftretens, ihrer Verbreitung, ihrer Akzeptanz und ihrer Übernahme in Wirtschaft und Gesellschaft (einschließlich Industrie und Infrastruktur) der EU sowie der damit verbundenen Risiken und Chancen";

-

Beitrag zur Erstellung eines "Bildes möglicher alternativer Zukünfte, die die gesellschaftlichen, wirtschaftlichen und politischen Bedingungen und Grenzen für die FuE-Politik der EU festlegen" (verfügbar als im Rahmen des Projekts erarbeitete Metaszenarien, European Commission 2016);

-

einen "strukturierten Überblick über die wichtigsten Megatrends, Trends und schwachen Veränderungssignale zu geben, die sich am ehesten auf die künftige F&I-Politik der EU und ihre Finanzierungsprioritäten sowie auf die Kapazitäten und die Leistung von STI auswirken dürften".

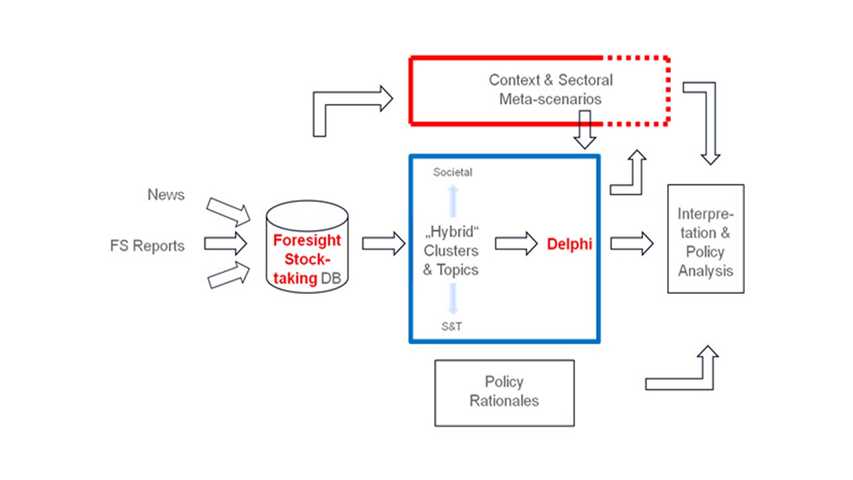

Der Workflow des BOHEMIA-Projekts und des Entwicklungsprozesses der Umfrage ist in der folgenden Abbildung 1 dargestellt.

Abbildung 1: Einbettung der Delphi-Studie in das Projekt BOHEMIA

Die zentrale Aufgabe bei Delphi-Befragungen ist die Formulierung der von den Befragten zu beurteilenden Aussagen oder Thesen. Eine große Herausforderung ist es, die zukünftige Entwicklung in einer klaren, eindeutigen und kurzen Sprache (optimal zwischen 10 und 15 Wörtern pro Aussage) zu beschreiben. Die BOHEMIA-Delphi-Thesen sollten keinen breiten Überblick über "alles, was noch kommt" geben, sondern die Beratung auf die für das kommende Rahmenprogramm relevanten Fragen der Forschung und Innovation (F&I) - in Wissenschaft und Technik, der Gesellschaft und der F&I-Praxis - konzentrieren. Die Anzahl der Thesen wurde auf maximal 150 festgelegt, um die Analyse überschaubar zu halten. Die Delphi-Thesen und -Argumente wurden auf der Grundlage mehrerer Quellen erarbeitet (siehe auch die obige Abbildung 1 zum Workflow):

-

Scannen von Internet und Literatur (z.B. Web of Science, neue journalistische Publikationen, Datenbankscanning);

-

Projekt-Meta-Szenarien;

-

Medienanalyse;

-

interner Konsortiumsworkshop (Mai 2016, Ziel: Themen aus der Scanning-Phase und anderen Quellen sammeln und vorstrukturieren);

-

Interviews (Aussagen von "Generalisten" und "Experten").

Die Thesen wurden verfeinert, mit Literatur untermauert und in einzelnen, kurzen Sätzen formuliert. Sie wurden in einem Scoping Workshop mit der Strategic Foresight Expert Group (SFRI) und dem Foresight Correspondents' Network diskutiert, erweitert und neu formuliert. Während dieser Veranstaltung wurden die Aussagen nach "Wissensfeldern" gruppiert. Anschließend durchliefen die Thesen mehrere zusätzliche Wellen der Verbesserung, des Feedbacks, der Aktualisierung durch Literatur und kurze Interviews, gefolgt von einer erneuten Gruppierung. Die endgültige Liste der Aussagen und Argumente für "Zeitpunkt der Realisierung" und "Bedeutung" wurde von der Europäischen Kommission für die weitere Bewertung ausgewählt. Der Fragebogen enthielt schließlich 147 Delphi-Thesen aus Wissenschaft und Forschung sowie breiter angelegte Fragestellungen, die vom Bedarf der Gesellschaft oder politischen Gegebenheiten ausgingen. Um das Auffinden der Themen für die Teilnehmenden und die Fragebogenführung zu erleichtern, wurden sie in Wissensbereiche gegliedert. Die Experten und Expertinnen konnten auf diese Weise selbst bestimmen, welche Thesen sie bearbeiten wollten. Am Ende der Befragung sollten sie dann ihre Expertise einschätzen.

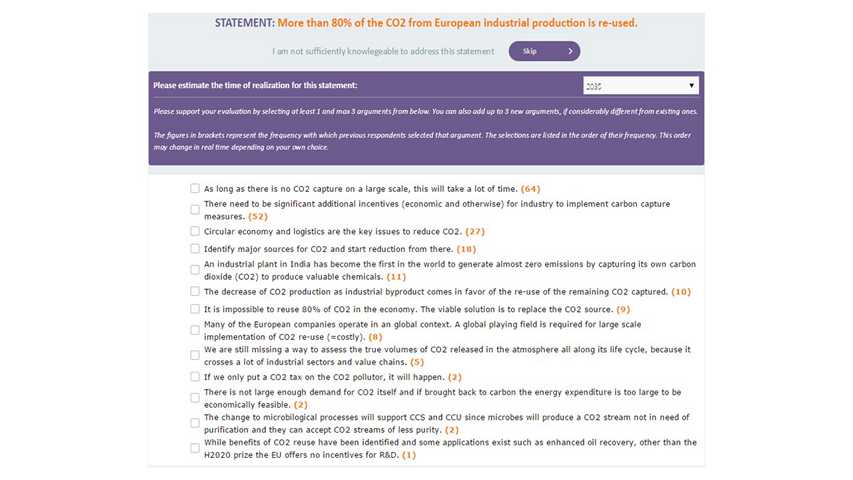

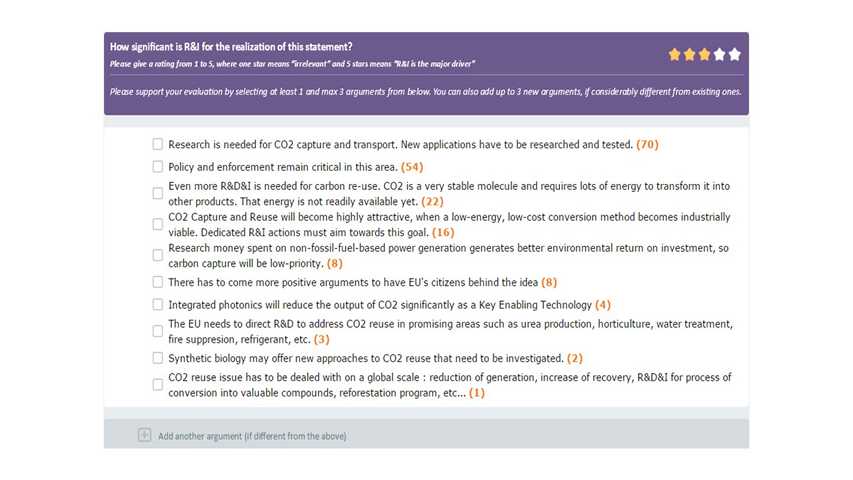

Die Thesen sollten von den Befragten hinsichtlich ihres wahrscheinlichen "Realisierungszeitpunktes" und ihrer "Bedeutung" (significance) bewertet werden. Jede These wurde mit zwei ersten Argumenten versehen, die als Rechtfertigung für die Einschätzungen der Befragten dienten und es ihnen so ermöglichten, mit den Ansichten der anderen Teilnehmenden zu interagieren. Die ersten Argumente dienten der Anschauung - die Teilnehmenden konnten sich entweder einem der Argumente anschließen und dieses ankreuzen oder ein bis zwei neue Argumente in ein offenes Feld schreiben. Der Delphi-Fragebogen lieferte somit neben den quantitativen Einschätzungen zu den beiden Hauptfragen jeder Aussage auch qualitative Daten in Form von Argumenten (d.h. die Begründung für die quantitativen Bewertungen). Der Fragebogen war nicht in einer beliebigen Realtime Delphi-Software (siehe z.B. Aengenheyster et al. 2017), sondern musste individuell programmiert worden (Prospectiva in Rumänien), da es für ein derartiges Format noch keine Standardsoftware gab.

Die Identifizierung und Auswahl der potentiellen Expert*innen begann schon früh im Projekt. Das Hauptkriterium bei der Auswahl der Teilnehmenden war die "Fachkompetenz", im weitesten Sinne definiert als ein ausreichender Wissensstand über ein "Feld" der Umfrage, d.h. die Fähigkeit, (fast) jede spezifische Aussage in diesem Feld zu beurteilen. So wurden die Expert*innen nach dem Inhalt und der Struktur der Thesen und ihren Wissensbereichen identifiziert. Es ist zu beachten, dass diese breite Definition von Expertise in Delphi-Designs üblich ist, die sowohl aus "Spezialisten" mit Nischenexpertise als auch aus "Generalisten" mit Interesse an einem breiteren Gebiet stichprobenartig erfasst werden. Da sich die Aussagen im Laufe des Formulierungsprozesses änderten, wurde die Auswahl neuer Expertinnen und Experten bis zum offiziellen Start der Befragung fortgesetzt. Die zur Teilnahme an der Delphi-Befragung eingeladenen Expertinnen und Experten wurden in eine gesonderte und unter Verschluss gehaltene Adress- und E-Mail-Datenbank aufgenommen.

-

Die ersten identifizierten Gruppen bestanden aus Expertinnen und Experten, die in den bestehenden Datenbanken, die den Konsortiumsmitgliedern zur Verfügung standen (z.B. Personen, die an früheren Delphi- oder anderen Befragungen teilgenommen hatten), aufgelistet waren, deren Kompetenzen und Wissensgebiete bekannt waren und die mit dieser Befragungslogik vertraut waren.

-

Zweitens erfolgte ein Screening nach vorhandenen Datenbanken (z.B. themen- oder sektorspezifische). Es wurden Experten aus ganz Europa gesucht, soweit ihre Daten öffentlich zugänglich waren, um den Datenvorschriften der Europäischen Union zu entsprechen.

-

Drittens gab es ein Konferenz-Screening zu bestimmten Themen und es folgte eine Suche nach einzelnen Experten mit Hilfe von semantischen Analyse- und Web-Mining-Tools. Im Web of Science wurde mit Hilfe von Schlüsselwörtern nach wissenschaftlichen Zeitschriftenartikeln gesucht - die identifizierten Autoren wurden ebenfalls zur Teilnahme aufgefordert.

-

Der vierte Schritt war eine kleine Co-Nominierung, auch „Schneeballsampling“ genannt, bei dem eine begrenzte Anzahl von identifizierten Expert*innen gefragt wurde, ob sie andere kennen, die sich beteiligen sollten. Die Mitglieder der ehemaligen Europäischen Plattform für Zukunftsforschung wurden ebenfalls eingeladen.

Insgesamt war geplant, etwa 15.000 Personen aus der ganzen Welt anzusprechen, um eine Beteiligung von mindestens 500 Personen zu gewährleisten. Erfahrungswerte der letzten Jahre zeigten einen immer geringeren Rücklauf der Antworten bei internetbasierten Befragungen, so dass das Projektteam mit einer pessimistischen Annahme startete. Die Zielvorgabe für Expert*innen mit Sitz außerhalb Europas, deren Beiträge u.a. als notwendig erachtet wurden, um eine "europäische Verzerrung" zu vermeiden, wurde auf 10% festgelegt. Um die Ansichten "informierter Außenstehender" zu den vorliegenden Themen einzubeziehen, wandte sich das Team auch direkt an Wissenschaftsjournalisten, Autoren von Wissenschaftsblogs sowie an Mitglieder europäischer Studentenorganisationen, Doktoranden in weiter gefassten Forschungsbereichen, Personen aus Nachwuchsforscherprogrammen und Studenten an Universitäten. Eine ausgewogene Verteilung der Expert*innen nach Ländern, nach Geschlecht und Hintergründen konnte erzielt werden (siehe die entsprechenden Abbildungen im Endbericht der European Commission 2017b).

Die Umfrage wurde am 5. Mai 2017 live geschaltet. Sie endete am 18. Juni 2017, nachdem die ursprüngliche Frist (2. Juni) zweimal verlängert wurde. Die Einladungen wurden an ca. 15.500 Personen versandt mit drei Erinnerungen an relevante Untergruppen (mit der Einladung, überhaupt teilzunehmen bzw. erneut teilzunehmen).

Die vorgegebene Zahl der Befragten wurde deutlich überschritten (um fast zwei Drittel, wenn man alle Personen berücksichtigt, die mindestens ein Feld vollständig ausgefüllt haben). Mehr als 10 % der Teilnehmenden kamen aus einem Land außerhalb der EU. Eine vergleichsweise größere Anzahl kam aus den Ländern des Konsortiums (Österreich, Deutschland, Italien, Rumänien). Dies lässt sich durch das Foresight-Team, das die Umfrage durchführte, erklären. Bekannten vertraut man seine Antworten eher an als anderen, die man nicht kennt. Aber auch die Niederlande und das Vereinigte Königreich sind in der Statistik gut vertreten. Nachfolgend eine Zusammenfassung der Beteiligungsstatistik:

-

1488 registrierte Nutzer auf der Plattform; davon

-

820 den Fragebogen für mindestens ein Wissensgebiet fertig ausgefüllt. Die Statistiken zu Teilnehmenden (Wirtschaftszweige, Wissensfelder, Länder, Geschlecht und Alter finden sich in European Commission 2017b).

-

727 Nutzer haben die gesamte Umfrage einmal durchlaufen und dabei ein oder mehrere Wissensfelder (bis zu 3) sowie ihre Profilseite ausgefüllt;

-

133 der letztgenannten Kategorie nahmen ein zweites Mal an der Umfrage teil, um die Verteilung der Ergebnisse und eine aktualisierte Liste der Argumente in ihrem/ihren Wissensbereich(en) zu konsultieren und möglicherweise ihre eigenen ersten Eingaben zu überarbeiten.

Die Befragten wurden vom Projektteam in einem per E-Mail versandten Brief zur Teilnahme an der BOHEMIA-Befragung eingeladen. Konkret wurden sie gebeten, die Website der Umfrage (bohemia-consultation.eu) zu besuchen und ein persönliches Konto einzurichten (im Wesentlichen eine E-Mail-Adresse anzugeben), um ihnen die Möglichkeit zu geben, die Umfrage nach Belieben zu beginnen, durchzuführen und zu verlassen. Nach dem Registrierungsschritt erhielten die Teilnehmer eine E-Mail mit einem personalisierten Link zum Fragebogen.

Beim Zugriff auf den Fragebogen wurde die Teilnehmerin/der Teilnehmer gebeten, anhand ihrer/seiner Expertise und Interessen eines von mehreren Feldern auszuwählen, unter denen die Delphi-Aussagen geclustert wurden. (Die Wissensfelder sind in zwei große Klassen eingeteilt: S&T Entwicklungen und F&I Policy Statements). Sie wurden auch aufgefordert, nach dem Ausfüllen des ersten Feldes jederzeit zurückzukehren, um weitere Felder (für maximal drei) auszuwählen.

Abbildung 2: Auswahl eines Wissensfeldes

Nach der Auswahl des oder der Felder wurde die erste Delphi-These zur Verfügung gestellt. Nachdem die Beurteilung auf einer Browserseite erledigt war, konnte der oder die Befragte zur nächsten Seite weitergehen - und so weiter, bis alle Thesen in dem ausgewählten Feld bearbeitet waren. In der oberen Hälfte der Seite war die These in fettgedruckten orangenen Buchstaben sichtbar, mit der Möglichkeit darunter, sie zu überspringen - falls der- oder diejenige sich nicht ausreichend informiert fühlte, um sie zu bewerten. (Falls jemand diese Option wählte, wurde der Rest der Seite ausgegraut und man konnte sofort mit der nächsten These fortfahren).

Unterhalb der Delphi-These wurde die oder der Befragte aufgefordert, den "Zeitpunkt der Realisierung" der Aussage einzuschätzen, wozu er oder sie eine der vorgegebenen Optionen aus einer Dropdown-Liste mit den Möglichkeiten „2025“, „2030“, „2035“, „2040“, „Nach 2040“, „Niemals“ oder „Ich weiß nicht.“ auswählen konnte. Nach Auswahl einer Einschätzung wurde der oder die Befragte gebeten, diese Einschätzung mit Argumenten zu untermauern, die entweder aus einer Liste bereits vorhandener Argumente ausgewählt oder selbst neu hinzugefügt werden konnten. Die bereits auf der Seite vorhandenen Argumente konnten durch einen Klick ausgewählt oder auch wieder abgewählt werden. Die neuen Argumente konnten in ein Feld geschrieben und anschließend bearbeitet bzw. entfernt werden. Das dann erscheinende Bild sah ähnlich wie in Abbildung 3 aus. Die Zahlen hinter den Argumenten zeigen an, wie viele Teilnehmende dieses Argument bereits gewählt haben.

Abbildung 3: Beispiel für die Einschätzung des Zeithorizontes inklusive der Argumente

Danach wurden die Teilnehmenden gebeten, die Bedeutung von Forschung und Innovation für die Realisierung der Aussage zu bewerten (wie in Abbildung 4). Das Bewertungssystem (1 bis 5 Sterne von „not significant“ bis „highly significant“) wurde kurz erläutert. Auch hier konnten Argumente ausgewählt oder hinzugefügt werden. In unserem Fall musste die These beurteilt werden, sonst konnte man nicht auf die nächste Seite weitergehen.

Abbildung 4: Beurteilung der Wichtigkeit („significance“) Anmerkung: Für den Typ von Aussagen in der obigen Abbildung wird die Bedeutung von "F&I für die Realisierung" beurteilt. Für einen anderen Typ von Aussagen lautete die Beurteilung anders.

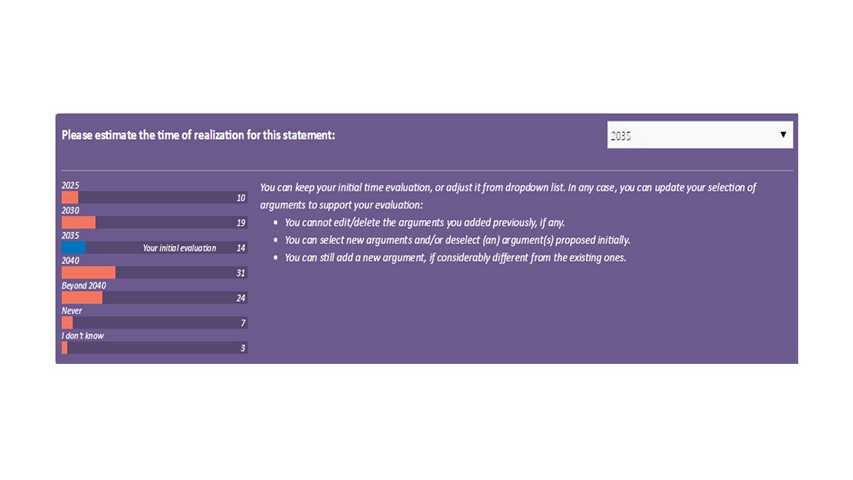

Nach Beurteilung einer einzelnen Delphi-These konnten sich die Proband*innen durch alle Aussagen bewegen, die mit dem selbst ausgewählten Feld zusammenhängen. Wer mit den Aussagen des Feldes fertig war, wurde außerdem aufgefordert, den Fragebogen ein zweites Mal aufzurufen, um die Einschätzungen der bisherigen Teilnehmer zu sehen und ggf. die eigenen Einschätzungen im Hinblick auf die neuen Informationen zu überarbeiten. Der Zugang zu dem neuen Abschnitt des Fragebogens war sofort möglich - konnte aber auf Wunsch des Teilnehmers später erfolgen. Das Feedback wurde erst angezeigt, wenn mindestens 15 Personen geantwortet hatten. Wenn dies nicht der Fall war, wurden die Teilnehmenden darüber informiert, dass sie zu einem späteren Zeitpunkt noch einmal eingeladen werden.

Nach dem erneuten Aufruf des Fragebogens zeigte der ausgegraute Hintergrund der Seite oben eine Nachricht an, die den Inhalt der neuen Seite und die neuen Aufgaben kurz erklärt.

Abbildung 5: Überarbeiten der Aussagen

Wie in Abbildung 5 bekommt jede*r individuell die Verteilung der Antworten angezeigt (orangefarbene Balken für alle, der blaue Balken für die eigene Antwort). Der/ die Teilnehmende wurde dann aufgefordert, die eigene ursprüngliche Bewertung des Realisierungszeitpunkts sowie die bisherigen Argumente entweder beizubehalten oder zu revidieren. Nach dem Ausfüllen der ersten oder zweiten „Runde“ des Fragebogens wurden die Befragten zu einem Abschnitt des Fragebogens geführt, in dem sie gebeten wurden, Informationen zu ihren "Profilen" (Alter, Geschlecht usw.) sowie zu ihrem Fachwissen auszufüllen. Auf der Seite mit dem Expertenprofil konnten die Teilnehmenden auch kurze Kommentare abgeben. Dann wurde der Fragebogen abgeschlossen. In diesem Projekt war durch das Erinnerungsmanagement und die Fragebogenführung daher eine Kombination aus Realtime Delphi (Echtzeit-Feedback) und einer Art zweiter Runde (Aufforderung, noch einmal von vorn zu beginnen, in gezieltem Anschreiben) gewährleistet.

Die Delphi-Aussagen wurden je nach Inhalt in zwei große Klassen eingeteilt:

-

Wissenschaftliche und technologische Entwicklungen (im Folgenden als "W&T-Aussagen" bezeichnet, siehe Abbildung 2); und

-

Forschungs- und innovationspolitische Aussagen (im Folgenden "Forschungsstatements" genannt).

-

Innerhalb jeder dieser Klassen wurden sie weiter in so genannte Wissensfelder geclustert. Dies sind z.B. die Felder für die Klasse "F&I Policy Statements":

-

Wirtschaft: Sharing, Wachstum, Nachhaltigkeit

-

Bildung & Qualifikation

-

Langlebigkeit & das Gesundheitssystem

-

Natürliche Umwelt, Klimawandel & Ozeane

-

Gesellschaft, Kultur, Digitalisierung & Governance

-

F&I-Praktiken

-

Arbeitsbedingungen & Beschäftigung

Eines der Ziele des Delphi war es, ein klareres Bild der Aussagen über zwei Dimensionen zu erhalten: den geschätzten Zeitpunkt ihrer Realisierung und ihre Bedeutung. Was letztere betrifft, waren die Fragen für jede Klasse von Aussagen sehr unterschiedlich. Konkret bezieht sich die "Signifikanz" bei Aussagen zu Wissenschaft und Technik auf die Bedeutung von Forschung und Innovation für die Realisierung des in der Aussage beschriebenen Sachverhalts. Bei den „Policy“-Fragen bezieht sich "Signifikanz" auf die Bedeutung des Sachverhalts für die zukünftige F&I-Politik, so das Thema denn realisiert wird.

Die Ergebnisse können in den Endberichten nachgelesen werden (European Commission 2017b und 2018). Es gibt unterschiedliche Rangfolgen der Thesen in tabellarischer Form,

-

Thesen, die voraussichtlich spätestens 2030 Realität werden: Mindestens 60% der Teilnehmer wählten als Realisierungszeitpunkt entweder 2025 oder 2030;

-

Thesen, die wahrscheinlich frühestens 2035 Realität werden: mindestens 60% der TeilnehmerInnen wurden als Realisierungszeitpunkt 2035, 2040 oder darüber hinaus ausgewählt;

-

Thesen, die wahrscheinlich nicht Realität werden: mindestens 60% der Befragten wählten als Antwort "nie"; und

-

Thesen mit unklarem Realisierungszeitraum: alle Argumente, die nicht in den oben genannten Klassen enthalten sind.

Übergreifende Analysen und statistische Tests wurden ebenfalls durchgeführt, allerdings nicht veröffentlicht, da die Europäische Kommission nur die Daten der einzelnen 147 Thesen sowie die Überblicks-Rangfolgen nutzen wollte. Diese wurden ausgiebig für eigene Analysen genutzt. Im Rahmen des BOHEMIA-Projektes wurden die wichtigsten Themen gefiltert, neu geclustert und sogenannte „Targeted Scenarios“ zusammengestellt und angereichert (European Commission 2018).

Mit einer argumentativen Delphi-Studie kann die Erhebung statistisch-quantitativer und argumentativ-qualitativer Daten optimal genutzt werden. Wie bei jeder Studie muss dabei aber die Erhebung entsprechend fachkundig vorbereitet und getestet werden. Unwissenschaftliche oder schlecht gemachte Fragebögen haben bereits einmal jegliche Art von Delphi-Studien in Misskredit gebracht (Sackman 1975, Coates 1975). Damals dauerte es lange, bis das Vertrauen in die Methode wiederhergestellt war. Die Möglichkeiten von Missbrauch, falscher Datenerhebung oder -auswertung bestehen bei Delphi-Umfragen genauso wie bei allen sozialwissenschaftlichen Studien. Ist die Erhebung jedoch gut und nach wissenschaftlichen Kriterien sauber vorbereitet (Gerhold et al. 2015; Mayring 2015 o.ä.) ist die Durchführung sehr schnell möglich (Feedback in Echtzeit) und auch schnell auswertbar.

Dadurch, dass die Organisator*innen bzw. Moderator*innen des Prozesses jederzeit Einblick in die Datenlage haben, können sie bei Missbrauch oder einseitiger Beantwortung mit Manipulationsabsichten auch sofort eingreifen. Eine direkte Manipulation der Ergebnisse in den eigenen Projekten konnte die Autorin noch nicht feststellen, was aber nicht bedeutet, dass diese unmöglich ist.

Durch die Online-Plattformen können jederzeit im Prozess und auch am Ende der Feldphase sofort die Rohdaten heruntergeladen und geprüft sowie ausgewertet werden. Damit kann die Schnelligkeit des Verfahrens optimal genutzt werden, sowohl beim Feedback als auch beim Abschluss der Feldphase. Grafiken und Tabellen können quasi sofort erstellt werden und bei guter Vorbereitung sogar sofort im gewünschten Design bereitstehen.

Ein besonderer Vorteil ist, dass über die Argumente sehr viele zusätzliche, qualitative Informationen erhoben werden können, die sonst häufig verborgen bleiben. Bei rein statistischen Angaben bleibt sonst häufig die Frage nach dem „Warum“ offen.

Aber auch die Nachteile sollen nicht verschwiegen werden. So ist zum Beispiel schwer nachzuvollziehen, wie die wechselseitigen Beeinflussungen stattfinden, insbesondere da bei einem Realtime Delphi nicht alle Personen mehrfach antworten und der Stand, auf dem sie antworten, unterschiedlich ist. Noch unklarer ist die wissenschaftliche Sachlage dann, wenn es sich um eine dynamische, argumentative Zukunftsbefragung handelt, die kein „richtiges Delphi“ ist, sondern jeden und jede nur einmal urteilen lässt (argumentative Zukunftsbefragung). Dann nämlich antwortet jede Person auf einem anderen Stand und hat nicht die Möglichkeit, das eigene Urteil zu revidieren.

Genauso wie bei allen Delphi-Varianten müssen die Thesen kurz, knapp, prägnant und eineindeutig formuliert sein. Dies erfordert eine große Genauigkeit in der Formulierung der Delphi-Thesen und schließt Themengebiete, die detaillierte Beschreibungen und Erläuterungen benötigen (viele aus gesellschaftswissenschaftlichen Bereichen) aus, weil diese nicht in der ausreichenden Kürze explizit gemacht werden können. In derartigen Fällen bieten sich andere Methoden (z.B. Szenario-Verfahren) an.

Genau wie bei allen Befragungen sind die Ergebnisse nicht „die Zukunft“, sondern ein Arbeitsmaterial, das für die weitere Prioritäten-Ausarbeitung, Planungs- oder Entscheidungszwecke genutzt werden kann (Cuhls 2003).

DAD Software gibt es leider (noch) nicht von der Stange, sondern die derzeitigen Software-Tools müssen für Argumente jeweils angepasst werden. In einigen Fällen oder bei höheren Ansprüchen ist eine komplette Neuprogrammierung erforderlich. Auch das Einspielen der ersten vorgegebenen Argumente zu „Lernzwecken“ und die Pretests sind ein nicht zu unterschätzender Aufwand in der Vorbereitung der Feldphase der Befragung.

Aufwändig - auch für die Teilnehmenden - ist der Umgang mit einem personalisierten Link oder einem passwortgeschützten Zugang bzw. „Konto“, damit jede*r mehrfach antworten kann und immer dort wieder beginnt, wo er oder sie stehengeblieben war bzw. wieder von vorn beginnen und navigieren kann. Dies erfordert Programmierung durch Fortgeschrittene. Datenschutzanforderungen müssen hier sehr ernst genommen werden.

Der Hauptnachteil ist, dass ein argumentatives Delphi schnell sehr zeitaufwändig werden kann - sowohl für teilnehmende Expert*nnen als auch für die Auswertenden. Viele Teilnehmende bedeutet in der Konsequenz auch viele Argumente, die trotz des Rankings (mehr noch natürlich, wenn sie nicht dynamisch gerankt sind) jedes Mal von den Teilnehmenden gelesen werden müssen. Der Fragebogen wird durch die neu hinzugefügten Argumente immer länger. Dabei verliert der Teilnehmer oder die Teilnehmerin schnell den Überblick und ist verleitet, die am häufigsten gewählten Argumente ebenfalls zu wählen - hier ist fast wieder das Konsensprinzip am Werk.

Gleiches gilt für die Auswertung. Auch hier verlieren die Auswertenden schnell den Überblick, so dass manchmal Werkzeuge wie MAXQDA zum Einsatz kommen, die zwar neutral auswerten, dafür aber die - manchmal wichtigen - Nuancen und Details nicht anzeigen. Oder die Liste der Befunde führt dazu, dass nur die oberen Ränge, die häufig gewählten Argumente angesehen werden, wobei die selten genannten Angaben manchmal ebenfalls interessante Zusatzinformationen bieten, aber weniger Beachtung finden. Hier sind daher nur „qualitative Auswertungen“ möglich.

Ein weiterer Nachteil ist, dass die so interessanten qualitativen Ergebnisse häufig in den durch die Tabellen und Grafiken bereits sehr langen Berichten und Publikationen keinen Platz mehr finden. Es werden häufig so viele Informationen generiert, dass diese nicht mehr alle untergebracht werden können. Dies geht mit dem Trend zu immer kürzeren und stärker visuell geprägten Berichterstattungen einher, verbunden mit immer kürzeren Aufmerksamkeitsspannen bei den Rezipienten. Die detaillierten Befunde können dann nicht mehr genannt werden - was für die teilnehmenden Expert*innen unbefriedigend ist, wenn sie sich doch derartige Mühe gegeben haben.

Damit können paradoxerweise die mit der neuen Methodik einhergehenden Vorteile der Informationsgenerierung gleichzeitig Nachteile der Methode sein.

Argumentative Zukunftsbefragungen und besonders die dynamischen argumentativen Delphi-Befragungen bieten viele neue Möglichkeiten, Informationen über mögliche Zukünfte zu generieren. Sie erheben nicht nur statistische Daten (Zahlen, Prozente), sondern auch die dazugehörigen Begründungen, die wiederum weitere Informationen und Erklärungen oder Erläuterungen enthalten.

Um dieses Potenzial zu nutzen, benötigt man eine Online-Plattform, die leider noch einen hohen Programmierungsaufwand erfordert. Die derzeitigen Online-Tools machen Befragungen zwar detaillierter möglich und an die Teilnehmenden anpassbar, aber Anpassung und Tests werden schwieriger und dauern länger.

Ein bewusster Missbrauch ist bei einem DAD genauso wie bei allen Realtime Delphi-Studien oder sozialwissenschaftlichen Befragungen möglich - bisher aber nicht bekannt. Biases können genauso wie bei anderen Befragungen auch auftreten, werden aber durch die Argumentationen und den kommunikativen Austausch häufiger offengelegt. Trotzdem ist nicht auszuschließen, dass falsche Handhabung der einfacher werdenden Tools und Fehlinterpretationen der Statistiken zunehmen werden.

Das Hauptproblem, das alle Befragungen in der heutigen Zeit haben, lässt sich aber auch durch ein DAD nicht lösen: In einer Zeit der Informationsüberflutung wird es immer schwieriger, fachkundige Personen für die Teilnahme an der Befragung zu gewinnen und zu halten, sie zu überzeugen, sich alles durchzulesen und mehrfach wiederzukommen, um die eigene Einschätzung ggf. zu revidieren. Konnte hier in den Anfangszeiten der nationalen Delphi-Studien (BMBF 1998, Cuhls 1997, BMFT 1993) noch mit dem Anreiz, dass Teilnehmende die Ergebnisse automatisch und früher als andere zugeschickt bekommen, punkten, so ziehen derartige Anreize heute nicht mehr. Sogar in Japan, in einem Land mit 50jähriger Erfahrung und nationalen Delphi-Studien alle fünf Jahre (letzte Version: NISTEP 2019) ist dieser Teilnahmeschwund zu beobachten. Wissenschaftliche Studien mit vielen Teilnehmenden („große Delphis“) wie BOHEMIA werden daher selten bleiben. Das Potential der „Kommunikation mit vielen“ über sehr unterschiedliche Zukunfts-Sachverhalte ist allerdings da. Mit DAD könnte tatsächlich Schwarmintelligenz (siehe auch Surowiecki 2017 bzw. 2004) genutzt und aktiviert werden, sofern diese wirklich existiert.

Inhaltlich bieten dynamische argumentative Delphi-Studien ein immenses Potential, nicht nur Einschätzungen zu Zukunftsthemen abzugeben, sondern auch qualitative Informationen für eine bessere Einordnung und ein Verständnis der (statistischen) Ergebnisse zu generieren.

Literaturverzeichnis

Aengenheyster, S., Cuhls, K., Gerhold, L., Heiskanen-Schüttler, M., Huck, J. & Muszynskae, M. (2017). Real-Time Delphi in practice — A comparative analysis of existing software-based tools. In: Technological Forecasting and Social Change. http://dx.doi.org/10.1016/j.techfore.2017.01.023.

Bundesministerium für Forschung und Technologie (BMFT) (Hrsg.) (1993). Deutscher Delphi-Bericht zur Entwicklung von Wissenschaft und Technik, Bonn.

Coates, J. F. (1975). In Defense of Delphi, A Review of Delphi Assessment, Expert Opinion, Forecasting and Group Process by H. Sackman. In: Technological Forecasting and Social Change, 7, S. 193-194..

Cuhls, K. (2019a). Horizon Scanning in Foresight - Why Horizon Scanning is only a part of the game. in: Futures and Foresight Science. DOI: 10.1002/ffo2.23.

Cuhls, K. (2019b). Die Delphi-Methode - eine Einführung. In: Marlen Niederberger und Ortwin Renn (Hrsg.): Delphi-Verfahren in den Sozial- und Gesundheitswissenschaften. Konzept, Varianten und Anwendungsbeispiele. Wiesbaden: Springer VS, S. 3–31.

Cuhls, K. (2016). Shaping the Future: Science and Technology Foresight Activities in Japan, with Special Consideration of the 10th Foresight. In: Asien, 140, S. 103-130.

Cuhls, K. (2012a). Zu den Unterschieden zwischen Delphi-Befragungen und “einfachen” Zukunftsbefragungen. In: Popp, R. (Hrsg.): Zukunft und Wissenschaft. Wege und Irrwege der Zukunftsforschung, Heidelberg: Springer.

Cuhls, K. (2012b). Die 9. Vorausschau-Studie in Japan 2010 – Ist sie schon überholt?, In: Wieczorek, I und Chiavacci, D (Hrsg.). Japan. Jahresband der VSJF. München: Iudicium.

Cuhls, K. (2009). Delphi-Befragungen in der Zukunftsforschung. In: Popp, R und Schüll, E (Hrsg.) Zukunftsforschung und Zukunftsgestaltung. Beiträge aus Wissenschaft und Praxis. Wissenschaftliche Schriftenreihe “Zukunft und Forschung” des Zentrums für Zukunftsstudien Salzburg, Band 1, Berlin, Heidelberg: Springer Verlag.

Cuhls, K., von Oertzen, J. & Kimpeler, S. (2007). Zukünftige Informations-technologie für den Gesundheitsbereich. Ergebnisse einer Delphi-Befragung, FAZIT-Schriftenreihe. www.fazit-forschung.de.

Cuhls, K. (2003). Setting Priorities, Seminar Workbook, UNIDO, Ankara.

Cuhls, K. (1998). Technikvorausschau in Japan. Ein Rückblick auf 30 Jahre Delphi-Expertenbefragungen, Heidelberg: Physica.

Dalkey, N. C. (1968). Predicting the Future, Santa Monica.

Dalkey, N. C. (1969a). Analyses From a Group Opinion Study. In: Futures, 2, 12, S. 541-551.

Dalkey, N. C. (1969b). The Delphi Method: An Experimental Study of Group Opinion, prepared for United States Air Force Project Rand, Santa Monica.

Dalkey, N. C., Brown, B. & Cochran, S. (1969). The Delphi Method, III: Use Of Self Ratings To Improve Group Estimates, Rand Corporation Paper RM-6115-PR, Santa Monica.

Dalkey, N. & Helmer, O. (1963). An Experimental Application Of The Delphi-Method To The Use Of Experts. In: Journal of the Institute of Management Sciences, in: Management Science, 9. S. 458-467.

Dalkey, N., Rourke, D. L., Lewis, R. & Snyder, D. (1972). Studies in the Quality of Life. Delphi and Decision-Making, Toronto/ London.

European Commission/ European Union (Hrsg.) (2018) Transitions at the Horizon: Perspectives for the European Union's future research- and innovation-related policies. https://ec.europa.eu/info/research-and-innovation/strategy/support-policy-making/support-eu-research-and-innovation-policy-making/foresight/activities/current/bohemia_en.

European Commission/ European Union (Hrsg.) (2017b): New Horizons: Data from a Delphi Survey in Support of European Union Future Policies in Research and Innovation; Report KI-06-17-345-EN-N; doi:10.2777/654172 or https://ec.europa.eu/research/foresight/index.cfm.

European Commission/ European Union (Hrsg.) (2017a) New Horizons. Future scenarios for research & innovation policies in Europe - Study. KI-04-17-245-EN-N, https://publications.europa.eu/en/publication-detail/-/publication/b2d78a84-3aae-11e7-a08e-01aa75ed71a1; DOI:10.2777/906131.

Friedewald, M., von Oertzen, J. & Cuhls, K. (2007). European perspectives on the information society: Delphi report. EPIS Deliverable 2.3.1. Karlsruhe: Fraunhofer ISI, Brussels: European Techno-Economic Policy Support Network (ETEPS). http://epis.jrc.es/documents/Deliverables/EPIS%202-3-1%20Delphi%20Report.pdf (zugegriffen: 6. Sept.2011, nicht mehr online verfügbar).

Gerhold, L. (2019). Real-Time Delphi. In: Marlen Niederberger und Ortwin Renn (Hrsg.): Delphi-Verfahren in den Sozial- und Gesundheitswissenschaften. Konzept, Varianten und Anwendungsbeispiele. Wiesbaden: Springer VS. S. 101-123.

Gerhold, L., Holtmannspötter, D., Neuhaus, C., Schüll, E., Schulz-Montag, B., Steinmüller, K. & Zweck, A. (Hrsg.) (2015). Standards und Gütekriterien der Zukunftsforschung. Heidelberg: VS Verlag für Sozialwissenschaften.

Gnatzy, T., Warth, J., von der Gracht, H., & Darkow, I. L. (2011). Validating an innovative real-time Delphi approach – A methodological comparison between real-time and conventional Delphi studies. In: Technological Forecasting and Social Change, 78 (9), 1681–1694. https://doi.org/10.1016/j.techfore.2011.04.006.

Gordon, T. & Pease, A. (2006). RT Delphi: An efficient „round-less“ almost real time Delphi method. In: Technological Forecasting and Social Change, 73(4), 321–333. https://doi.org/10.1016/j.techfore.2005.09.005.

Grupp, H. (Hrsg.) (1995). Der Delphi-Report, Stuttgart: dva-Verlag.

Häder, M. (2009). Delphi Befragungen. Ein Arbeitsbuch (2. Aufl.). Wiesbaden: Springer VS. https://doi.org/10.1007/978-3-658-01928-0.

Kuwahara, T., Cuhls, K. & Georghiou, L. (2008). Foresight in Japan. In: Georghiou, L et al. (Hrsg.) The Handbook of Technology Foresight, Concepts and Practice, PRIME Series on Research and Innovation Policy, Cheltenham: Edward Elgar Publishing. S. 170-184.

Mayring, P. (2015). Qualitative Inhaltsanalyse. Grundlagen und Techniken, 12. vollständig überarbeitete und aktualisierte Auflage. Weinheim: Julius Beltz.

National Institute of Science and Technology Policy (NISTEP) (2019). 「第11 回科学技術予測調査 S&T Foresight 2019 総合報告書」. (11. Foresight zu Wissenschaft und Technologie). NISTEP REPORT, Nr. 183, Tokyo. DOI: https://doi.org/10.15108/nr183.

Sackman, H. (1975). Delphi Critique. Expert Opinion, Forecasting, and Group Process, Rand Corporation, Toronto/ London: Rand publishing.

Surowiecki, J. (2017). Die Weisheit der Vielen: Warum Gruppen klüger sind als Einzelne und wie wir das kollektive Wissen für unser wirtschaftliches, soziales und politisches Handeln nutzen können. Kulmbach: Plassen. (Original: Surowiecki, J (2004) The wisdom of crowds. Anchor: Doubleday.)

UEFISCDI (2013). Argumentative evaluation of proposed smart specializations for 2013-2020. www.cdi2020.ro.

Zipfinger, S. (2007). Computer-aided Delphi – An experimental study of comparing round-based with real-time implementation of the method. Linz: Trauner.

Cuhls, Kerstin: Prof. Dr. phil. Kerstin Cuhls ist seit 1992 am Fraunhofer-Institut für System- und Innovationsforschung (ISI) in Karlsruhe als Projektleiterin im Foresight tätig. Sie ist Honorarprofessorin an der Universität Heidelberg, Centre for East Asian and Transcultural Studies (CATS), Japanologie.

[1] Folgende Projekte in Rumänien können als Belege angeführt werden, sind aber nur als Berichte erschienen: (UEFISCDI 2013) - Argumentative evaluation of proposed smart specializations for 2013-2020 (www.cdi2020.ro), (UEFISCDI, 2020) - Argumentative evaluation of proposed smart specializations for 2021-2027 (UEFISCDI, 2016) - Argumentative evaluation of key societal trends relevant for education in 2030, as part of the project Educated Romania, coordinated by the Romanian Presidency and (UEFISCDI, 2014) - Argumentative evaluation of the relevance of different policies in supporting the 2020 vision for public administration in Romania.

[2] Zu Übungszwecken benutzen wir aber auch analoge Verfahren (z.B. bei den Methodentrainings der Bundesakademie für Sicherheitspolitik, BAKS, oder in der Lehre an der Freien Universität Berlin), bei denen Papier-Fragebögen weitergegeben werden, jeder eine Bewertung vornimmt, den Bogen weitergibt und am Ende das Ergebnis abgelesen werden kann.

[3] Jedenfalls dann, wenn sie korrekt ausgeführt werden und erst dann Feedback gegeben wird, wenn bereits eine ausreichende Zahl an Teilnehmenden vorhanden ist, siehe auch unten.

[4] Dies sind in der Regel die ersten 10 oder 20, damit die Anonymität gewahrt bleibt. Wenn nur ein oder zwei Personen vorher geantwortet haben, kann durchaus auf die Antwortenden geschlossen werden.

Volltext ¶

-

Volltext als PDF

(

Größe:

498.0 kB

)

Volltext als PDF

(

Größe:

498.0 kB

)

Lizenz ¶

Jedermann darf dieses Werk unter den Bedingungen der Digital Peer Publishing Lizenz elektronisch übermitteln und zum Download bereitstellen. Der Lizenztext ist im Internet unter der Adresse http://www.dipp.nrw.de/lizenzen/dppl/dppl/DPPL_v2_de_06-2004.html abrufbar.

Empfohlene Zitierweise ¶

Cuhls, K. (2021). Das dynamische, argumentative Delphi (DAD) – erste Projekte. Zeitschrift für Zukunftsforschung, 1, None. (urn:nbn:de:0009-32-54012)

Bitte geben Sie beim Zitieren dieses Artikels die exakte URL und das Datum Ihres letzten Besuchs bei dieser Online-Adresse an.